AIの政治利用をめぐって:「ジリノフスキーAI」や「安倍AI」の登場という恐怖

国際AIの最大の問題点

私は、AIの最大の問題点が誤った科学的信念にあると考えている。最近のAIの成功は、コンピューターに大量のデータを覚え込ませて、ある目的のためにより有効な結果をもたらす手段を高い確率で選び出すという統計処理に起因している。

囲碁のようなルールが比較的明確な場では、AIによる迅速な統計処理が人間の能力を凌駕してゲームに勝てることが明確になったわけである。顔認証にAIを利用する場合、顔と個人の同定の正答確率が問題になる。

ここでも、統計処理に基づくAIがより高い確率で顔と個人の一致を可能にしている。気づいてほしいのは、「各々の分子に対して確かなことは言えなくても、莫大な数の分子の集まりに対しては確実に予言できることがある」としてミクロな構成要素(量子力学や古典力学)とマクロな現象(熱力学)のつながりを探る統計力学で利用されている確率や統計学がAIに利用されている事実だ。

つまり、AIは「各々の個人に対して確かなことは言えなくても、莫大な数の個人の集まりに対しては確実に予言できることがある」という信念のもとに成立しているのだ。

問題は、「各々の個人に対して確かなことは言えなくても」という部分を前提としながらも、「不均質な分布は均質な状態(平衡)へと向かう、そして向かうべきだ」という近代以降の統計力学の信念がそのあとにつづいている点にこそある。

ここで思い出さなければならないのは、近代化の途上で解体されつつあった空間や時間を社会基盤として整備し、すべての事物、場所(土地)、財などを固定し測定することで最終的に国家が人間主体であるかのように振舞うことを可能にした学問体系のことだ。それを可能にしたのは統計学(statistics)であり、国家(states)の影がちらつく存在として生まれた学問なのである。

つまり、AIは国家と深く結びついている統計学によって、「莫大な数の個人の集まりに対して」働きかけることが「均質な状態(平衡)へと向かう、そして向かうべきだ」と信じられていることになる。

この信念は、たとえば、「効率的利他主義」(effective altruism)という、世界でよいことをすることを最大化するための哲学的運動にもつながっている。

一部の信奉者は、何百万年にもわたって善を最大化することを考える長期主義という哲学を支持している。

ただし、そこには、「均質な状態(平衡)へと向かう、そして向かうべきだ」という信念が貫かれており、AIのもつ信念と基本的に変わらない。

複数あるAI倫理基準

私は、こうした信念自体を否定しようとは思わない。ただ、これとは別の信念もありうることに気づいてほしいのだ。ここで私が注目したのが岡崎乾二郎著『抽象の力』である。彼は、つぎのように記述している。

「雲や霧などの細かい水の粒子の分布、濃度の偏差を形態=対象として扱うことは、当然、対象そのものに対する感受性をも変える。対象は固体ではない。さまざまなパラメータの重なりに見出される偏差が確率的に現象させる偶有的存在にすぎない。

濃度(ポレンシー)という偏差が力(エネルギー)であり運動を生む。形態の知覚はこの運動過程にだけ存在する。つまり「何かを見る」という知覚もまた運動であり過程の一部である。この意味で形態は客観より、むしろ主観に属するようにも現象する。

いや、それは主観そのものこそ、この(統計)力学的過程によって成立する確率的な存在にすぎないからであった。主観とは、いわば形態の輪郭を引き寄せ、まとめているところの重心=焦点である」。

「むしろ主体とは扱う技術形式、言語ごとに異なる主体として別人のように組成され直す。こうしたバフチンなどの(遡ればフロイトから批判的に継承された)認識を思い起こせば、複数の技術体系=パラダイム、それに基づく複数の主体の束として、個々の人格があっても何ら不思議はない。

われわれは豆腐とチーズと納豆を一緒くたにすることは決してないし、ワインとビールを混同することもない。

それは、一人の人物の能力なのではなく、ワインとビール、豆腐とチーズの技術体系の違い、それぞれの形式的完結性、論理的整合が、それぞれを判断する別の主体を要請し、作り出すからである」。

Business ethics or justice symbol on wooden cubes. Ethical corporate culture, business integrity and moral principles concept.

ここで岡崎氏が言わんとしているのは、複数ありうる形式を排除し単一の形式内で思考する(豆腐とチーズと納豆を一緒くたにする)のではなく、複数の異なる形式に沿って主体を分裂させ、それらを自らのうちに葛藤させて味わうことの重要性だ。

つまり、「お好み焼きでは語りえないピザ、ピザでは語りえないお好み焼き。ゆえにお好み焼きとピザは融合せず、われわれはその両方を、別の時間、別の態度(判断基準)をもって味わうことができると自覚する」ことが大切なのである。

こう考えると、AI倫理を考えるための判断基準は複数存在することになる。AIを可能にした技術体系は蒸気機関を可能にした技術体系とは違う。ゆえに、効率性や利便性だけを優先する判断基準だけを善とみなすような基準はおかしい。別の態度があってもいいのだ。

数値化とリスク区分という問題も

AIを可能にする技術体系に注目すると、そこには、他の技術体系にはないルールや独自の「文法」のようなものがあり、それが規範をつくり出すことに気づく。

具体的に言えば、感情を含めてあらゆるものを数値化するという見方に基づいて、その数値を0か1というデジタル化によって表示する技術の延長線上にAIは成り立っている。

この技術体系に伴うルールには、そもそも数値化の是非という倫理上の論点が浮上する。AI倫理の議論には、数値化をめぐる議論が不可欠ということになる。

加えて、AIは確率や統計に基づいているのであり、最終的にビッグデータに基づく確率的因果論がはじき出す数値に基づく判断が観察者たる人間の事後的な独断的判断と同じになる可能性を残している。

そこには、この技術体系にリスク区分という「文法」のようなものが組み込まれていることに気づいてほしい。

独断的判断は人種的偏見だけでなく、さまざまな差別意識に基づいている。リスク区分という考え方によって、同じ人間でありながらリスク評価基準の吟味なしにさまざまなリスクが独り歩きするようになっている。

たとえば男女に平均寿命の差がある以上、長生きする女性の年金保険料を男性より引き上げるべきだとか、黒人居住区の犯罪発生率が高い以上、そこに住む黒人の損害保険料を高くすべきだといった議論がある。

だが、保険はもともと互いに保険に入ることでリスクを分かち合い、お互いの結束を強め、相互扶助の精神に基づいてリスク自体を減らすという効果をもつものとして構想された。

リスクを安易に切り分けて、そこに統計を持ち込んで公正を理由にアルゴリズムを作成すると、AI が歪んだ結果を人間に強いることになりかねない。

つまり、リスク区分という考え方を一貫してとりつづけている技術体系に潜む文法にも倫理上の問題がある。安易なリスク区分という論点もAI倫理の議論に不可欠なのだ。つまり、AIが基づいている確率や統計自体のもつリスク区分に大きな問題点があることにも気づいてほしい。

AI規制は当然

このようにみてくると、AIを規制するのは当然であると思われる。米国や日本は「ガイドライン」を定める程度の緩い規制のもとで、民間企業の活力をいかそうとしているようにみえる。

これに対して、欧州は法規制による厳格なルールによってAIの危険性をできるだけ削ごうとしているように感じられる。

AIが人間の存亡にまで影響を与える以上、厳しい規制が当然であると、私は考える。ただ、その法規制が国別に行われること大きな危惧をいだかざるをえない。国家と統計との結びつきを考えれば、一国による規制が不十分なものに終わる可能性が高い。

ロシアが2016年の米大統領選にSNSなどを利用して干渉したように、生成AIは簡単に国境を越えられるから、国レベルの規制だけでは実効性がない。国家を超えたレベルでの厳しい規制こそ求められているように思われる。

(注1)

GPT-4の前段として、GPT-3が米国の研究機関OpenAIによって開発され、マイクロソフトが2019年にOpenAIに10億ドルを投資し、GPT-3のライセンス供与で合意したという経緯がある。このGPT-3は、AIで利用されているニューラル・ネットワークをベースとしている。ニューラル・ネットワークがインターネット全体をスキャンして、次の単語を予測するという作業を、人間がどのように言語を組み合わせているかを学習することでできるようになったのだ。このGPT-3をもとにしたチャット可能なロボット(チャットボット)として2022年11月から人工知能言語モデルChatGPTが話題となったが、2023年3月、その最新版としてGPT-4を組み込んだChatGPTが誕生する。GPT-4では、前バージョンよりも流動的に反応するようになり、文書だけでなく画像にも反応可能で、より幅広いタスクに対応できるようになった。

OpenAIの主要投資家でありパートナーでもあるマイクロソフトは、インターネット検索エンジンBingに、ほぼすべてのトピックについて自由なテキスト会話を行うことができる同様のチャットボットを追加した。検索エンジン最大手のGoogleもチャットボット「Bard」を2023年3月に米国と英国の限られたユーザーに向けてリリースした。ほかにも、アマゾンのクラウドコンピューティング部門Amazon Web Services(AWS)は、同じくAIのスタートアップであるHugging Faceとの提携を拡大すると発表している。アップルは、仮想アシスタントのシリ(Siri)を含む製品全体で新しいAIをテストしていると伝えられている。

〇ISF主催トーク茶話会:孫崎享さんを囲んでのトーク茶話会のご案内

※ウクライナ問題関連の注目サイトのご紹介です。

https://isfweb.org/recommended/page-4879/

※ISF会員登録およびご支援のお願いのチラシ作成しました。ダウンロードはこちらまで。

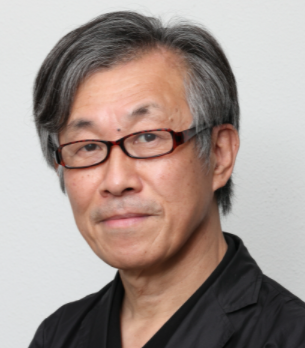

塩原俊彦

塩原俊彦

1956年生まれ。一橋大学大学院経済学研究科修士課程修了。学術博士。評論家。『帝国主義アメリカの野望』によって2024年度「岡倉天心記念賞」を受賞(ほかにも、『ウクライナ3.0』などの一連の作品が高く評価されている)。 【ウクライナ】 『ウクライナ戦争をどうみるか』(花伝社、2023)、『復讐としてのウクライナ戦争』(社会評論社、2022)『ウクライナ3.0』(同、2022)、『ウクライナ2.0』(同、2015)、『ウクライナ・ゲート』(同、2014) 【ロシア】 『プーチン3.0』(社会評論社、2022)、『プーチン露大統領とその仲間たち』(同、2016)、『プーチン2.0』(東洋書店、2012)、『「軍事大国」ロシアの虚実』(岩波書店、2009)、『ネオ KGB 帝国:ロシアの闇に迫る』(東洋書店、2008)、『ロシア経済の真実』(東洋経済新報社、2005)、『現代ロシアの経済構造』(慶應義塾大学出版会、2004)、『ロシアの軍需産業』(岩波新書、2003)などがある。 【エネルギー】 『核なき世界論』(東洋書店、2010)、『パイプラインの政治経済学』(法政大学出版局、2007)などがある。 【権力】 『なぜ「官僚」は腐敗するのか』(潮出版社、2018)、『官僚の世界史:腐敗の構造』(社会評論社、2016)、『民意と政治の断絶はなぜ起きた:官僚支配の民主主義』(ポプラ社、2016)、Anti-Corruption Policies(Maruzen Planet、2013)などがある。 【サイバー空間】 『サイバー空間における覇権争奪:個人・国家・産業・法規制のゆくえ』(社会評論社、2019)がある。 【地政学】 『知られざる地政学』〈上下巻〉(社会評論社、2023)『帝国主義アメリカの野望:リベラルデモクラシーの仮面を剥ぐ』(社会評論社、2024)、『ネオ・トランプ革命の野望:「騙す人」を炙り出す「壊す人」』(発行:南東舎、発売:柘植書房新社、2025)がある。 『ネオ・トランプ革命の野望:「騙す人」を炙り出す「壊す人」』(発行:南東舎、発売:柘植書房新社、2025)