「知られざる地政学」連載(11) AI規制に関する最新動向:英国でのAI セイフティ・サミットをめぐって

映画・書籍の紹介・批評国際

2023年11月1~2日、英国で人工知能(AI)の安全性に関するサミット(AI Safety Summit)が開催される。各国の閣僚やAI企業のCEO、学識経験者、市民社会の代表者など約100人が参加する。特別ゲストとして、カマラ・ハリス米国副大統領も出席する予定だ。この原稿の脱稿日は10月31日なので、この記事が公表されるころには、日本でもこのサミットについて多少とも報道されることになるだろう。

リシ・スナク英首相はAIの安全で責任ある開発に関する的を絞った迅速な国際的行動を推進する目的で同サミットを開催し、英国を世界のAI規制の最前線に位置づけたいと考えているらしい(2023年9月15日付「ザ・ガーディアン」を参照)。だが、少なくとも日本のマスメディアはAI規制をめぐる包括的な情報を提供しているようには思えない。そこで、今回はAI規制について考察する。

過去の研究業績

AI規制は地政学上も重要なテーマであるため、拙著においても何度も分析対象としてきた。たとえば、『サイバー空間における覇権争奪』では、序章「技術と権力」の第4節「AIと倫理、軍事、そして問題点」(37~50頁)、第1章「米国」の第5節「AIへの取り組みに遅れ」(92~103頁)、第3章「中国」の第3節「AIに賭ける」(161~169頁)などでAIについて考察した。

2023年9~10月に刊行したばかりの『知られざる地政学』〈上巻〉では、第4章「科学技術の「進歩」と情報操作」の第5節「AIの安全性をめぐって」(231~272頁)において、今回のサミットにかかわる問題を詳述した。〈下巻〉でも、第3章「サイバー空間」の第3節「AI依存の恐怖」(273~285頁)で、AI問題を取り上げた。

AI規制をめぐる基礎知識

ここでは、これらの分析を踏まえて、簡単な概説を展開したい。まず、結論めいたことを記そう。先の『知られざる地政学』〈上巻〉に、つぎのように書いておいた。

「AIの発展によって、覇権国アメリカの影響力拡大をねらってきた米国はそう簡単に自らの影響力拡大の手段たるAIを本格的に規制しようとはしないだろう。それは、遺伝子組み換え(遺伝子工学)やゲノム編集という最先端科学技術への対応と同じだろう。ただ、AIについては、中国のほうが発展しているとの見方も可能だから、中国のAI発展を抑え込むために米国政府がAI規制の旗振り役を果たす可能性がないわけではない。」

おそらく米国政府に代わって、英国政府がAI規制において主導的な役割を担いたいというのがスナク首相のサミット開催の理由だろう。

AI開発には長い歴史がある。このため、ここで丁寧に説明するだけの余裕はない(簡単に理解するためには、〈上巻〉の234~244頁を参照してほしい)。ただ、一つだけ確認しておきたいことがある。それは、AI開発が軍事と深く結びついている点だ。具体的には、自律型兵器としての「キラーロボット」の開発・実用化といった問題がある。AI規制というとき、軍事にかかわるAIという側面が抜け落ちてしまうことがある(とくに日本)。これでは、AI規制の議論の根幹が無視されてしまうから、十分に注意を払う必要がある。

最近、AIが脚光を浴びるようになったのは、Generative Pre-Trained Transformer 3(GPT-3)やGPT-4といった、生成するという意味の「Generative」という名称のついたAIが開発されたからにほかならない。これらは、ラージ・ランゲージ・モデル(LLM)と呼ばれる生成型AIの一種ということができる。つまり、あくまで言語に基づいた会話が人間らしくできるようになり、「ChatGPT」が利用できるようになったにすぎない。

AGI実現はまだ遠い先

〈上巻〉で説明したように、研究者らはすでにChatGPTのようなチャットボットを、ボットが生成するテキストに基づいて行動を起こすことができるシステムに変える「AutoGPT」の開発に取り組んでいる。2023年6月10日付のNYTに公表された「AIはどのように人類を滅ぼす可能性があるのか?」という刺激的なタイトルの記事によれば、理論的には、AutoGPTは、情報の取得、アプリケーションの使用、新しいアプリケーションの作成、さらには自分自身の改良など、オンラインでほとんどすべてのことを行うことができる方法だが、「AutoGPTのようなシステムは、現在、うまく機能していない」と書いている。

まだこのレベルに達していない以上、人間の知能と同等かそれを超える真の人工知能(artificial general intelligence , AGI)の水準までにはほど遠い状況にある。ただ、投資家の資金を集めたい研究者らのなかには先走った見解をのべる者もいる。マイクロソフトの研究者らは、「GPT-4はAGIへの大きな一歩であると言って差し支えないだろう」と論文のなかで指摘している。「小規模なモデルには存在しないが、大規模なモデルには存在する能力であり、小規模なモデルの性能向上を外挿するだけでは予測できない能力」を意味する「創発的能力」をもつようになったことがその根拠に一つとされる。この能力は、(1)具体的に指定されておらず、訓練でも出てこないような目標を達成する、(2)具体的で定量化可能な目標の達成に集中する、(3)長期的な計画を立てる――といった行為を可能にする。だが、「創発的能力は、研究者の分析によって引き起こされた蜃気楼である可能性が高い」との批判もある。

ただ、AIの今後を考えると、AI規制は喫緊の課題であるように思われる。とくに、すでにAIの軍事利用がさかんに行われている現状を考えると、AI規制は必要だろう(EUや中国などのAI規制や出遅れている米国や日本の動向については〈上巻〉に詳しく書いておいたのでそちらを参照してほしい)。

サミットでの議論

つぎに、「AIセイフティ・サミット」で予定されている議論を紹介しよう。これまでの報道によると、サミットの初日には、企業関係者、市民社会メンバー、そして中国のような潜在的な地政学的ライバルを含む国々が、より幅広く参加する。これらの会議の目的は、フロンティアモデルのリスクと機会について共通の理解を示すコミュニケを作成することである。サミットの2日目には、G7諸国やその他の西側同盟国の代表者、主要AI企業の幹部など、20人前後の少人数のグループが出席する予定だ。

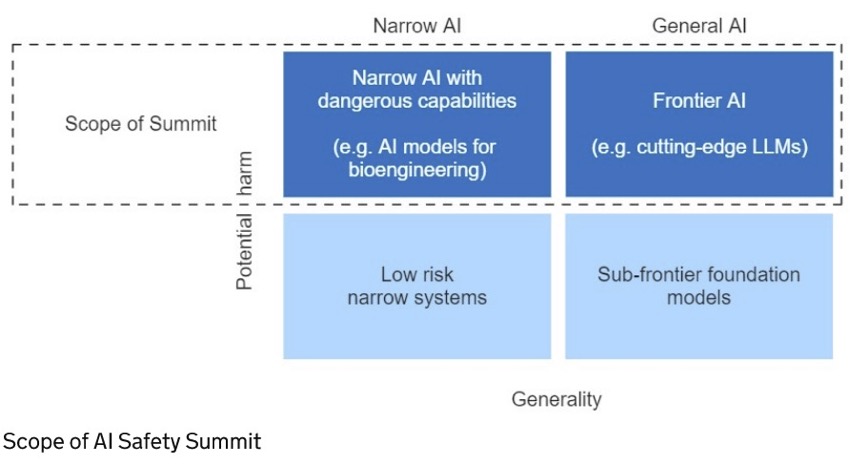

事前に公表されている「ガイダンス」によれば、サミットでは、AIシステムがもたらす可能性のあるリスクに基づき、特定のタイプのAIシステムに焦点を当てる。具体的には、「フロンティアAI」と「狭域AI」の二つである(下図参照)。前者は、「多様なタスクをこなし、現在の最先端モデルと同等かそれ以上の能力を持つ、非常に高性能な汎用AIモデル」を意味し、技術的進歩の最先端にあり、それゆえにもっとも多くの機会を提供するが、同時に新たなリスクももたらす。AGIは間違いなくフロンティアAIであろう。

他方で、後者は「学習アルゴリズムが単一のタスクまたは狭い範囲のタスクのセットを実行するように設計されており、タスクの実行から得られた知識は自動的に適用または転送されることはない、特定のタイプのAI」をいう。

図 AIセイフティ・サミットの範囲

(出所)https://www.gov.uk/government/publications/ai-safety-summit-introduction/ai-safety-summit-introduction-html

この二つのAIのかかえている共通のリスクとして、「悪用リスク」と「制御不能リスク」の二つがある。前者では、生物学的攻撃やサイバー攻撃、危険な技術の開発、重要なシステムへの干渉などにおいて、悪意ある行為者が新しいAIの能力によって支援される場合、歯止めがかからなければ、人命の損失を含む重大な被害をもたらす可能性がある。後者は、人間の価値観や意図に沿うことを求める先進的なシステムから生じる、AIに対するコントロールができなくなるリスクを意味している。

そのうえで、このサミットでは、とくにフロンティアAIの安全性に注目し、以下の五つについて合意をめざす。①フロンティアAIがもたらすリスクと対策の必要性の共通理解、②国内および国際的な枠組みをどのようにサポートするのが最善かを含む、フロンティアAIの安全性に関する国際協力のための前進プロセス、③フロンティアAIの安全性を高めるために個々の組織が取るべき適切な措置、④モデル能力の評価や、ガバナンスを支援するための新たな標準の開発など、AIの安全性に関する研究における潜在的な協力分野、⑤ AIの安全な開発を確保することで、AIが世界的にどのように活用されるかを紹介する――というのがそれである。

どうなるAI規制

拙著『知られざる地政学』〈上巻〉で紹介したように、欧州連合(EU)の欧州委員会は2021年4月21日、欧州議会に対して、「人工知能に関する調和された規則(人工知能法)を定め、特定の連合立法を修正すること」を求める提案を決めた。その提案を修正した交渉指令案が2023年5月11日、域内市場委員会と自由権規約委員会によって賛成84票、反対7票、棄権12票で採択された。欧州議会は2023年6月14日、法律案を可決した。法案はまだ、欧州連合(EU)加盟国の首脳で構成される欧州理事会の交渉待ちだ。7月にEU理事会で、欧州議会議員、欧州委員会、EU諸国が参加する三者交渉がなされ、2023年末までに最終版の法律案が採択される見込みである。その後、発効までに2年ほどかかるとみられている。

AIセイフティ・サミット直前の動き

AIセイフティ・サミット直前に二つの動きがあった。ジョー・バイデン大統領は10月30日、「AIの安全、安心、信頼できる開発と利用に関する大統領令」に署名した。AIの開発と利用を、八つの指導原則と優先事項に従って進め、管理する方向性が示されている。同日、米国、フランス、ドイツ、イタリア、日本、英国、カナダ、欧州連合(EU)を含むG7は、人工知能(AI)に関する国際指導原則と、広島AIプロセスの下でのAI開発者の自主的行動規範に合意した。

米国の大統領令は、AIの軍事利用という安全保障にかかわる軍事・情報分野と、それ以外の分野とを峻別している。前者については、国家安全保障に関する覚書の作成が指示されており、「覚書は、国家安全保障システムの構成要素として、あるいは軍事・諜報目的で使用されるAIのガバナンスに対処するものとする」と明記されている。

興味深いのは、米大統領令にもG7の国際指導原則にも、AIを利用して作成したことを示す「ラベルづけ」を奨励する方向性が示された点だ。前者では、バイデン政権下で、「効果的なラベリングとコンテンツ証明メカニズムの開発を支援し、米国人が、コンテンツがAIを使用して生成されたものとそうでないものを判断できるようにする」と書かれている。国際指導原則には、「組織はさらに、ラベル付けや免責事項など、他の仕組みを導入することが奨励される」と記されている。

なお、7カ国主要先進国G7は、2023年4月30日、G7デジタル・技術相会合において、「責任あるAI」の推進などを盛り込んだ共同声明を採択し、生成AIについては、今年後半に改めてG7で会合の場を設けガイドラインの策定をめざすとした。6月のG7広島サミットの冒頭の会合で、生成AIについての議論が行われ、閣僚級による議論の枠組み「広島AIプロセス」をもとに国際的なルール作りを進行することで各国が合意した。といっても、ガイドラインといった中途半端な、いわば日本的で曖昧なやり方が意味をもつかは疑問である。とくに、AIの軍事的側面をまったく無視したアプローチは批判されるべきだろう。

中国の出方

中国は、〈上巻〉でも紹介したように、2023年4月、生成型AIサービスの管理に関する措置として、意見募集案を公表した。その一方で、7月には、百度(バイドゥ)が開発したAIチャットボット、アーニー(Ernie)のような生成AI製品に対し、中国共産党が定義する学習データの「真実性、正確性、客観性、多様性」を確保するよう求めるようになった。

さらに、10月18日になって、「Global AI Governance Initiative」(全球人工智能治理倡议)を発表した。そのなかでは、「私たちは、世論操作、偽情報の拡散、他国の内政・社会制度・社会秩序への介入、他国の主権を危うくする目的でAI技術を使用することに反対する」と記されている。しかし、これがAIの軍事利用を含めたものであるとは考えにくい。このイニシアティブには、「技術独占や一方的な強制手段によって障壁を作り出し、グローバルなAIのサプライチェーンを混乱させることにも反対する」とも書かれており、中国政府にとって都合の悪いことに反対するという姿勢が鮮明に打ち出されているように思われる。

出遅れるばかりの日本

ここでは、米国における詳しいAI規制に向けた動きは紹介しない。拙著『知られざる地政学』〈上巻〉を参考にしてほしい。いずれにしても、米国ではAI規制をめぐるさまざまな議論はあっても、具体的な法律が制定間近といった状況にはない。前述した大統領令はAI規制の方向性を示しているだけで、法制化の見通しについては不透明だ。

日本政府はいつものように、右顧左眄しつつ、とくに米国政府の対応をながめているだけだ。2023年5月9日、岸田文雄首相はChatGPTに代表される生成AI技術の急速な進歩を受け、政府に「AI戦略会議」を新たに設置すると正式に表明したが、AIの軍事利用という観点が向け落ちている。さらに、同会議のメンバーをみても、AI問題の「専門家」と呼びうる人物がいるとは思えない。

余談だが、英国では、10月、オンライン安全法が制定された。同法の200を超える条項には、プラットフォームが対処を求められる違法コンテンツが幅広く網羅されており、プラットフォームはユーザー(とくに子ども)がオンラインで目にするものに対する「注意義務」を負うことになる。大企業から小規模のプラットフォームやメッセージングアプリに至るまで、企業は利用者の年齢認証に始まり、新しい要求事項の長いリストに従う必要がある。この法律は、英国で相当数のユーザーを抱えるプラットフォームすべてに適用される。英国の電気通信規制当局であるOfcomが法執行にあたり、新ルールに従わない企業には、最高1800万ポンド(約2190万ドル)または年間売上高の10%のいずれか大きい方の罰金が科される。

こうした画期的な法律まで制定済みの英国はいわば、デジタル関連規制で最先端にある。だからこそ、AI規制でも世界をリードしようとしているわけだ。これとは対照的なのが日本政府である。出遅ればかりが目立つ。しかも、マスメディアの報道は「いびつ」であり、御用学者の登用ばかりが目立つ。そして、一知半解な「専門家」がテレビや新聞に登場し、皮相な議論を開陳し、国民をだます。だまされた国民はだます側に加担し、混迷はますばかりという構図となる。これが、日本のいまの構造であり、ウクライナ報道も、旧統一教会報道も、ジャニーズ事務所報道も同じ構造のもとにある。こうして戦争の足音が着実に近づいているのだ。

– – – – – – – – – – – – – – – – – – – – – – – – –

● ISF主催トーク茶話会:小林興起さんを囲んでのトーク茶話会のご案内

● ISF主催公開シンポジウム:WHOパンデミック条約の狙いと背景〜差し迫る人類的危機〜

※ISF会員登録およびご支援のお願いのチラシ作成しました。ダウンロードはこちらまで。

ISF会員登録のご案内

塩原俊彦

塩原俊彦

1956年生まれ。一橋大学大学院経済学研究科修士課程修了。学術博士。評論家。『帝国主義アメリカの野望』によって2024年度「岡倉天心記念賞」を受賞(ほかにも、『ウクライナ3.0』などの一連の作品が高く評価されている)。 【ウクライナ】 『ウクライナ戦争をどうみるか』(花伝社、2023)、『復讐としてのウクライナ戦争』(社会評論社、2022)『ウクライナ3.0』(同、2022)、『ウクライナ2.0』(同、2015)、『ウクライナ・ゲート』(同、2014) 【ロシア】 『プーチン3.0』(社会評論社、2022)、『プーチン露大統領とその仲間たち』(同、2016)、『プーチン2.0』(東洋書店、2012)、『「軍事大国」ロシアの虚実』(岩波書店、2009)、『ネオ KGB 帝国:ロシアの闇に迫る』(東洋書店、2008)、『ロシア経済の真実』(東洋経済新報社、2005)、『現代ロシアの経済構造』(慶應義塾大学出版会、2004)、『ロシアの軍需産業』(岩波新書、2003)などがある。 【エネルギー】 『核なき世界論』(東洋書店、2010)、『パイプラインの政治経済学』(法政大学出版局、2007)などがある。 【権力】 『なぜ「官僚」は腐敗するのか』(潮出版社、2018)、『官僚の世界史:腐敗の構造』(社会評論社、2016)、『民意と政治の断絶はなぜ起きた:官僚支配の民主主義』(ポプラ社、2016)、Anti-Corruption Policies(Maruzen Planet、2013)などがある。 【サイバー空間】 『サイバー空間における覇権争奪:個人・国家・産業・法規制のゆくえ』(社会評論社、2019)がある。 【地政学】 『知られざる地政学』〈上下巻〉(社会評論社、2023)がある。